Il concetto di Human-In-The-Loop può ostacolare la diffusione della tecnologia all’interno della “National Security Enterprise” in presenza di limitazioni alla disponibilità dei dati.

Nell’attuale configurazione della Comunità Intelligence, la gerarchia governa l’accesso ai dati. Generalmente, l’accesso ai dati sensibili è limitato, in particolare HUMINT e SIGINT. Dato l’elevato costo (umano e tecnico) del loro trattamento, gli analisti spesso non possono accedervi a causa delle minacce di compromissione. Ciò accade ancora di più con la politicizzazione dell’Intelligence quando è la politica a favorire le carriere. L’accesso limitato ai dati sensibili frustra le comunità di analisti e rende l’Intelligenza Artificiale inutile.

Come ogni materia prima, i dati devono essere raccolti, affinati e resi disponibili per l’analisi. I dati sono rinnovabili, autogeneranti e virtualmente senza limiti. Entro il 2025, la sfera globale dei dati supererà i 175 zettabyte rispetto ai 33 zettabyte del 2018 (Reinsel, Gantz, Rydning, 2018). Entro il 2020, l’Internet degli oggetti (IoT) sarà composta da oltre 50 miliardi di dispositivi connessi, che producono e consumano dati in modo silenzioso e inesorabile (Davis 2018). Negli ultimi anni, l’analisi Intelligence è diventata sempre più impegnativa a causa di un aumento senza precedenti del volume e della velocità dei dati sia grezzi che strutturati (principalmente dati testuali, audio e video, che rappresentano il 95% di tutti i Big Data in circolazione, Gandomi, Haider 2015), raccolti attraverso piattaforme classificate e open-source. Interrogare i Big Data strutturati è relativamente semplice. I dati non strutturati, invece, sono allo stato grezzo e ancora da trattare e interpretare, ma – per questi motivi – anche molto preziosi. Ne sono un esempio i social media, le e-mail, i blog e i contenuti multimediali (Sivarajah, Kamal, Irani, Weerakkody, 2017). L’abnorme volume di informazioni, ancora da elaborare prima di diventare “actionable Intelligence”, sta sovraccaricando le capacità cognitive di ogni singolo analista e di ogni team. Dal 1995 al 2016, la quantità di lettura richiesta a un analista di Intelligence americano medio dedicato ad un paese a bassa priorità è aumentata da 20.000 a 200.000 parole al giorno. La previsione per il 2025 è circa un volume di dati digitali dieci volte superiore a quello attuale (Regens 2019).

Una volta che i dati siano stati contestualizzati e trasformati in informazioni potenzialmente rilevanti per l’Intelligence, la cognizione umana diventa vitale per la sua interpretazione. La capacità di astrazione umana conserva, infatti, un notevole vantaggio rispetto alla macchina. Per ricordare un’immagine, un testo, un numero, un essere umano necessita di vederlo un numero di volte notevolmente inferiore a quello di una macchina (Turing 1950).

La potenza della tecnologia può essere efficacemente impiegata per aumentare le prestazioni umane nell’Intelligence Loop “alimentando” le capacità umane (cognitive e fisiche) con l’apporto che le macchine possono fornire, traslando in avanti la “frontiera delle possibilità di produzione” della Comunità Intelligence ed aumentando il volume di dati che l’uomo può elaborare senza ridurre la sua capacità di concentrazione, apprendimento e identificazione degli elementi chiave incorporati in quei flussi di dati.

“OUTSOURCING” DELLE FUNZIONI VITALI DEL CICLO DELL’INTELLIGENCE

Il concetto di Human-In-The-Loop può ostacolare la diffusione della tecnologia all’interno della National Security Enterprise in presenza di “outsourcing” dei compiti tecnologici dell’Intelligence Loop.

Ragioni etiche potrebbero indurre i contractor, non appartenenti alla “National Security Enterprise” (condizionati da accordi di non divulgazione, ma disinteressati emotivamente al concetto intrinseco di tutela della sicurezza nazionale), a rifiutare di sviluppare tecnologie per i teatri di guerra.

La partnership tra Google e il Dipartimento della Difesa statunitense relativa al “Project Maven” fornisce un caso di studio. Nell’aprile 2017, il Pentagono ha istituito il “Algorithmic Warfare Cross-Functional Team” (AWCFT) noto come “Project Maven”, per integrare Machine Learning e Big Data a livello operativo militare (Work 2017).

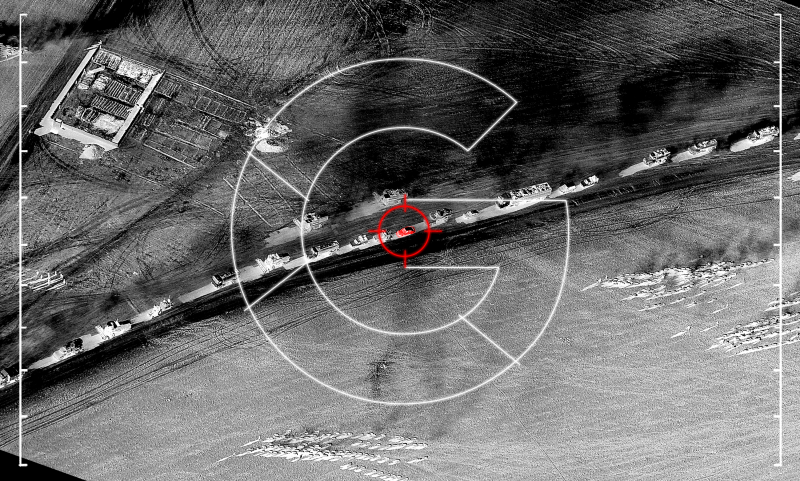

Google ha collaborato al “Project Maven”, applicando le proprie soluzioni di Intelligenza Artificiale all’attività di velivoli senza equipaggio (Unmanned Aerial Vehicles, UAV) sia nel targeting dei droni (Fang 2018) che nell’analisi delle riprese effettuate (Conger, Cameron 2018).

Per aiutare gli analisti ad esaminare gli oggetti nelle immagini, Google ha fornito al Pentagono il suo “TensorFlow”, una API (Application Programming Interface, Pettey 2017) open-source utilizzata nelle applicazioni di Machine Learning di Google per riconoscere gli oggetti sui dati (Conger, Cameron 2018). Il primo obiettivo della partnership è stato quello di sviluppare la capacità di rilevare automaticamente circa 38 classi di oggetti regolarmente presenti nei filmati dei droni militari.

Nell’aprile 2018, circa 3.100 dipendenti di Google hanno firmato una lettera che invitava l’allora CEO Pichai Sundararajan ad abbandonare il “Project Maven”. Nonostante le assicurazioni fornite dal management di Google di essersi limitato al solo rendere disponibile il software open-source per il riconoscimento degli oggetti (fruibile da qualsiasi client di Google Cloud) per aiutare l’aviazione militare statunitense ad alleggerire il carico di lavoro dei suoi analisti, sulla spinta interna Google ha dovuto abbandonare il progetto all’inizio del 2019.