Il cammino dell’AI Act, la proposta di legge europea finalizzata a regolamentare l’utilizzo dell’intelligenza artificiale (IA) – una prima assoluta nel mondo – prosegue. Ieri infatti il Parlamento europeo ha dato il primo via libera alla misura e approvato una serie di emendamenti, tra cui precisi limiti sulle tecnologie di riconoscimento facciale, ritenuto una delle maggiori minacce per la tutela dei diritti fondamentali di consumatori e cittadini.

Anche gli eurodeputati Brando Benifei del Pd, co-relatore del testo di legge insieme a Dragoş Tudorache di Renew Europe, e Vincenzo Sofo di Fratelli d’Italia hanno parlato con Start proprio di questo tema così sensibile sul quale tutti concordano che sia necessario un intervento a livello europeo.

I PASSI AVANTI SULL’AI ACT

Con 84 voti a favore, 7 contrari e 12 astenuti, gli eurodeputati hanno dato l’ok alla posizione del Parlamento Ue sull’AI Act, che mira a stabilire delle norme europee per regolare l’intelligenza artificiale nei suoi usi e soprattutto nella sua influenza sulla vita quotidiana delle persone.

Il testo è stato approvato nel corso della riunione congiunta delle commissioni per il Mercato interno e la protezione dei consumatori (Imco) e per le Libertà civili, la giustizia e gli affari interni (Libe) del Parlamento Ue.

FOCUS RICONOSCIMENTO BIOMETRICO

I gruppi politici hanno inoltre raggiunto un accordo sul divieto del riconoscimento biometrico in tempo reale nei luoghi pubblici – idea accarezzata dal ministro dell’Interno, Matteo Piantedosi, che l’ha proposto per ospedali, aree commerciali e stazioni di Roma, Napoli e Milano, dove però solo pochi giorni fa ha dichiarato che nel capoluogo lombardo “non esiste un’emergenza sicurezza”.

A tal proposito ieri Benifei ha detto: “Con questa posizione diciamo chiaramente a Piantedosi e ai suoi colleghi che avessero le sue stesse opinioni che non intendiamo cedere a una idea di società del controllo dove tutti sono sorvegliati e sorvegliabili per una falsa idea di sicurezza”.

LE PROSSIME TAPPE

Ora si attende il voto in plenaria, previsto tra il 12 e il 15 giugno, per dare avvio ai triloghi, ovvero i negoziati inter-istituzionali, con il Consiglio dell’Ue. L’obiettivo è portare a compimento il progetto entro la primavera del 2024, che coincide anche con la fine della legislatura e le elezioni europee.

LA SCALA DI RISCHIO DELL’AI ACT

L’AI Act, oltre a proporre delle regole comuni ai Ventisette, va a identificare i rischi che l’IA può porre nel momento in cui entra in contatto con l’essere umano. Non tutti, però, sono considerati ugualmente.

Come spiegava Benifei a Start, ci sono rischi considerati più elevati dal regolamento, come quelli che riguardano i diritti fondamentali, la salute o la sicurezza e per i quali vengono quindi richieste ai produttori di sistemi di IA procedure di certificazione che hanno bisogno, tra le varie cose, di una verifica sulla qualità dei dati, sul controllo umano, sulla spiegabilità degli algoritmi.

Ci sono poi sistemi i cui usi sono invece ritenuti a rischio insostenibile e, dunque, vietati come nel caso delle telecamere a riconoscimento biometrico negli spazi pubblici, la polizia predittiva e l’utilizzo dell’IA per il riconoscimento emotivo in alcuni ambiti.

Anche per Sofo, l’AI Act deve essere uno strumento che pone dei limiti dove la tecnologia va a sfociare nella violazione della privacy, del diritto al trattamento dei dati personali e nel social scoring, ovvero il sistema di credito sociale ideato dalla Cina per classificare la reputazione dei propri cittadini.

Sofo aveva inoltre portato l’esempio di quanto già accade nel Metaverso, dove l’utilizzo dei dati e la creazione di avatar permettono di studiare i comportamenti e ottenere analisi predittive anche sulle opinioni politiche, con evidenti conseguenze sulla libertà personale e sulla manipolazione delle persone.

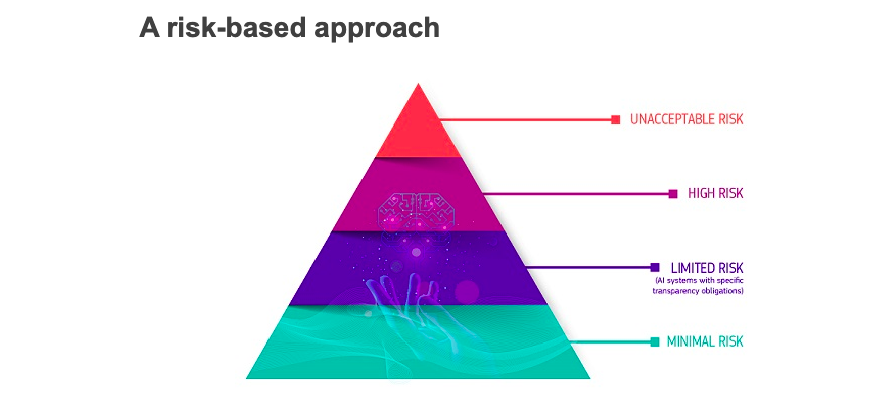

LA PIRAMIDE DEI RISCHI DELL’IA

Per stabilire a livello comune i rischi, il testo di legge prevede una piramide di quattro livelli: minimo (videogiochi abilitati per l’IA e filtri anti-spam), limitato (chatbot), alto (assegnazione di punteggi a esami scolastici e professionali, smistamento dei curricula, valutazione dell’affidabilità delle prove in tribunale, chirurgia assistita da robot) e inaccettabile (tutto ciò che rappresenta una “chiara minaccia per la sicurezza, i mezzi di sussistenza e i diritti delle persone”, come l’assegnazione di un ‘punteggio sociale’ da parte dei governi).

Per i sistemi a rischio basso non è previsto nessun intervento, per quelli a livello limitato ci sono delle richieste di trasparenza. Le tecnologie a rischio alto devono, invece, essere regolamentate e quelle di livello considerato inaccettabile sono vietate.

E LA RICERCA?

Regolamentare l’IA, però, non vuol dire chiudere all’innovazione e al progresso e per questo gli eurodeputati hanno previsto esenzioni per le attività di ricerca e per i componenti dell’IA forniti con licenze open-source.

Benifei ha, infatti, parlato con Start di “limiti limitati” per la ricerca poiché il regolamento interessa non lo studio ma il prodotto finale inserito nel mercato e che interagisce con gli esseri umani. Anzi, ha auspicato a una maggiore azione comune a livello europeo anche per poter competere con potenze come Stati Uniti e Cina.

Su questo anche Sofo ha detto che è necessario trovare un equilibrio tra la tutela della libertà, dei diritti fondamentali e la ricerca, lo sviluppo di una tecnologia che comunque nel mondo andrà avanti e che altrimenti verrà importata se non avremo un’autonomia europea strategica.