Come regolamentare l’intelligenza artificiale? L’Unione europea se lo chiede da circa due anni e ora il documento, denominato AI Act e proposto dalla Commissione Ue nell’aprile 2021, è in discussione al Parlamento europeo, dove sarà votato il prossimo 26 aprile.

Tuttavia, la strada sembra in salita perché alla votazione seguiranno i triloghi – ovvero i negoziati interistituzionali dell’Ue volti a finalizzare e attuare la legge – che però, soprattutto nel caso di leggi così complesse, possono richiedere molto tempo perché i legislatori negoziano i punti critici e rivedono le proposte.

Infatti, secondo Ursula Pachl, vicedirettrice dell’Organizzazione europea dei consumatori (BEUC), “non sarà applicabile per altri quattro anni”.

GLI OBIETTIVI DELL’AI ACT

Come ha spiegato il Consiglio europeo lo scorso dicembre quando ha adottato la sua posizione comune (orientamento generale) relativa alla normativa sull’intelligenza artificiale, l’AI Act nasce dall’esigenza di assicurare che i sistemi di IA immessi sul mercato Ue “siano sicuri e rispettino la normativa vigente in materia di diritti fondamentali e i valori dell’Unione”.

COSA C’È NELL’AI ACT

La proposta di legge si concentra principalmente sul rafforzamento delle norme relative alla qualità dei dati, alla trasparenza, alla supervisione umana e alla responsabilità. Vuole anche affrontare le questioni etiche e le sfide di attuazione in vari settori, dalla sanità all’istruzione, dalla finanza all’energia.

Inoltre, va di pari passo con altre iniziative, compreso il piano coordinato sull’IA, che mira ad accelerare gli investimenti nel settore in Europa.

Dovrebbe essere istituito anche un Consiglio europeo per l’intelligenza artificiale, che supervisionerebbe l’attuazione del regolamento, emettendo pareri e raccomandazioni da fornire alle autorità nazionali.

I LIVELLI DI RISCHIO

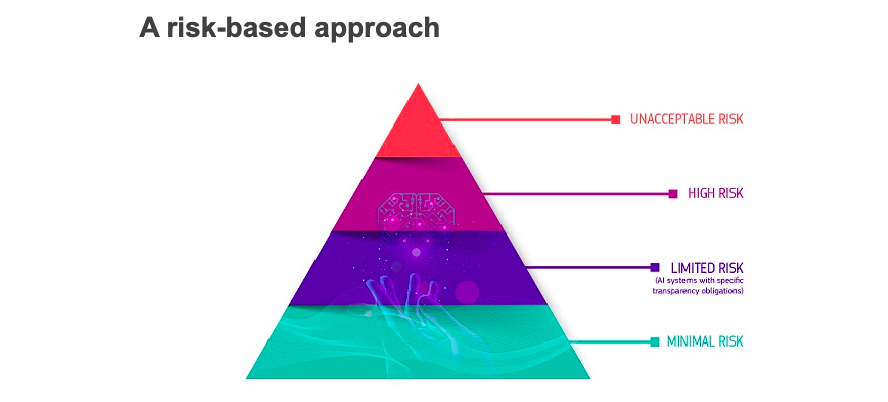

La proposta si basa su un sistema di classificazione che determina il livello di rischio che una tecnologia di IA potrebbe rappresentare per la salute e la sicurezza o i diritti fondamentali di una persona. Sono previsti quattro livelli di rischio: inaccettabile, elevato, limitato e minimo.

I sistemi con rischi limitati e minimi, come i filtri antispam o i videogiochi, possono essere utilizzati con pochi requisiti oltre agli obblighi di trasparenza, spiega il sito del World Economic Forum; mentre, quelli considerati con rischio inaccettabile, come il social scoring governativo e i sistemi di identificazione biometrica in tempo reale negli spazi pubblici, sono vietati con poche eccezioni.

Infine, è stato fatto esplicito riferimento all’esclusione delle finalità militari, di difesa e di sicurezza nazionale dall’ambito di applicazione della normativa sull’IA.

I SISTEMI DI IA AD ALTO RISCHIO

I sistemi di intelligenza artificiale ad alto rischio sono consentiti, ma gli sviluppatori e gli utenti devono attenersi a regolamenti che richiedono test rigorosi, un’adeguata documentazione della qualità dei dati e un quadro di responsabilità che specifichi la supervisione umana.

Rientrano, per esempio, in questa categoria veicoli autonomi, dispositivi medici e macchinari per infrastrutture critiche.

E CHATGPT?

Il discusso ChatGPT di OpenAI non fa parte dei sistemi ritenuti ad alto rischio ma l’AI Act delinea anche le norme relative alla cosiddetta “IA per finalità generali”, ovvero sistemi che possono essere utilizzati per diversi scopi e con vari gradi di rischio, tra cui ci sono anche i sistemi di IA generativa basati su modelli linguistici di grandi dimensioni.

LE SANZIONI

Stando a quanto afferma il World Economic Forum, il testo propone “pesanti sanzioni per la mancata conformità”: per le aziende, le multe possono raggiungere i 30 milioni di euro o il 6% del fatturato totale e anche la presentazione alle autorità di vigilanza di documentazione falsa o fuorviante può comportare multe.

“A prova di futuro e di innovazione, le nostre regole interverranno dove strettamente necessario: quando sono in gioco la sicurezza e i diritti fondamentali dei cittadini dell’Ue”, ha dichiarato Margrethe Vestager, vicepresidente della Commissione europea e Commissario europeo per la concorrenza.

COSA PENSA IL GARANTE DELL’IA ACT

In occasione di un convegno tenutosi presso l’Università degli Studi di Padova, la vicepresidente del Garante, Ginevra Cerrina Feroni, si è espressa positivamente circa l’IA Act.

“La scelta europea – ha spiegato – ha come stella polare quella di accompagnare l’innovazione tecnologica impedendo che diventi regressiva da un punto di vista sociale, di rendere la tecnologia uno strumento di promozione dei diritti e delle libertà e non invece strumento di discriminazione”.

Da quanto riporta Privacy Italia, “secondo Feroni la bozza è abbastanza compiuta e ha visto significativi miglioramenti negli ultimi mesi, come l’estensione degli obblighi di trasparenza e di conformità all’intero ciclo di vita dell’IA, una più corretta ripartizione di ruoli tra i vari attori coinvolti e l’estensione del contrasto al social scoring ai soggetti privati, anche se ‘si dovrà migliorare’”.

Nell’articolo viene poi sottolineata la necessità di scegliere al più presto “l’autorità di riferimento che dovrà garantire l’applicazione e il rispetto del Regolamento […] per non prestare il fianco al rischio di vuoti normativi o conflitti di competenze”.