Il Pentagono sta mettendo alle strette Anthropic.

Secondo quanto rivelato da Axios, il Dipartimento della Difesa degli Stati Uniti sta valutando la possibilità di interrompere o ridimensionare la partnership con la società di intelligenza artificiale guidata dal fondatore e ceo Dario Amodei, a causa della sua insistenza nel mantenere alcune restrizioni su come l’esercito statunitense utilizza i suoi modelli AI.

La notizia emerge in seguito al rapporto del Wall Street Journal secondo cui il Pentagono ha utilizzato il modello Claude di Anthropic (tramite Palantir) nell’operazione di cattura del presidente Maduro in Venezuela.

Inoltre, il nodo delle limitazioni dell’AI riguardo all’uso militare si aggiunge alle preoccupazioni espresse dal ceo Amodei riguardo le “armi completamente autonome” e “sorveglianza domestica di massa”, nel podcast Interesting Times del New York Times. Senza dimenticare che Anthropic dovrebbe anche affrontare una crescente inquietudine interna tra alcuni ingegneri rispetto alla collaborazione con il Pentagono, secondo una fonte a conoscenza della situazione citata da Axios. E proprio il posizionamento dei dipendenti complicherebbe la possibilità di allinearsi pienamente alle richieste del Dipartimento della Difesa, secondo la testata.

La scorsa settimana Reuters ha riportato che il Pentagono stava sollecitando le principali aziende di intelligenza artificiale, tra cui OpenAI e Anthropic appunto, a consentire l’utilizzo dei loro strumenti anche su reti classificate, eliminando gran parte delle restrizioni normalmente previste per gli utenti.

Tutti i dettagli.

LA PRESSIONE SULLE BIG AI

Secondo quanto dichiarato ad Axios da un alto funzionario dell’amministrazione, il Pentagono sta facendo pressione su quattro importanti laboratori di intelligenza artificiale affinché consentano all’esercito di utilizzare i loro strumenti per “tutti gli scopi legittimi”, anche nelle aree più delicate dello sviluppo di armi, della raccolta di informazioni e delle operazioni sul campo. L’obiettivo è ottenere un accesso più ampio e meno vincolato agli strumenti di IA, sia in contesti classificati sia in contesti non classificati.

Il funzionario ha sottolineato che Anthropic non ha accettato questi termini e che, dopo mesi di negoziati difficili, la pazienza del Pentagono starebbe diminuendo.

LE LIMITAZIONI IMPOSTE DA ANTHROPIC

Da parte sua la startup americana avrebbe mantenuto una linea rigida su due ambiti specifici, considerati non negoziabili: la sorveglianza di massa degli americani e gli armamenti completamente autonomi. Anthropic insiste sul fatto che queste due aree debbano restare off-limits per l’utilizzo dei suoi modelli.

Nel quadro generale descritto dal funzionario, tuttavia, il problema sarebbe rappresentato dall’esistenza di una considerevole area grigia nel definire cosa rientri o meno in queste categorie. Secondo la stessa fonte, risulterebbe impraticabile per il Pentagono dover negoziare singoli casi d’uso con Anthropic, o correre il rischio che Claude blocchi inaspettatamente determinate applicazioni.

L’OPERAZIONE VENEZUELANA E L’UTILIZZO DI CLAUDE

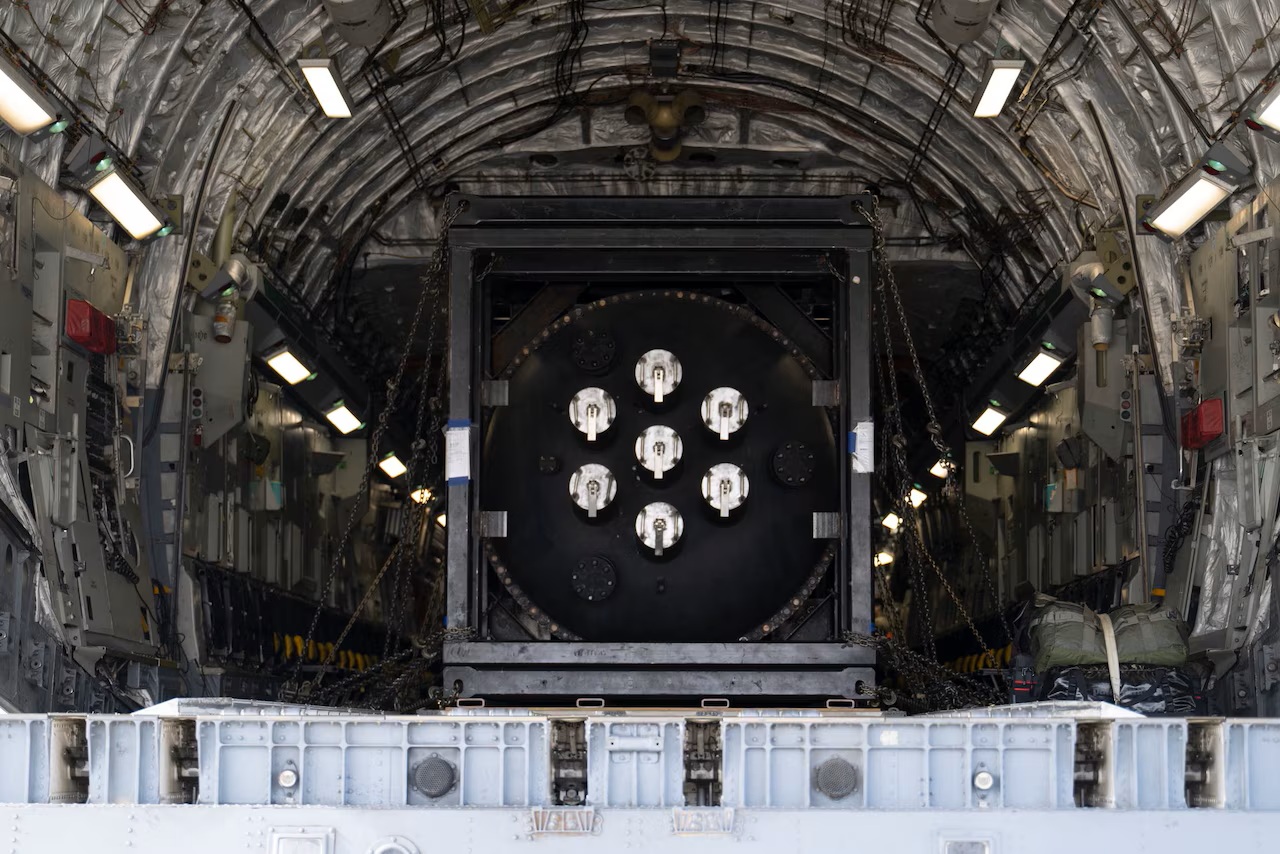

Le tensioni tra Anthropic e il Pentagono si sarebbero aggravate di recente a causa dell’utilizzo di Claude da parte dell’esercito nell’operazione per catturare Nicolás Maduro in Venezuela, attraverso la partnership di Anthropic con la società di software di data intelligence Palantir.

LA POSIZIONE DELLA SOCIETÀ GUIDATA DA DARIO AMODEI

Un portavoce di Anthropic ha negato categoricamente questa ricostruzione, affermando che l’azienda “non ha discusso l’utilizzo di Claude per operazioni specifiche con il Dipartimento della Guerra. Non ne abbiamo discusso nemmeno con alcun partner del settore al di fuori delle discussioni di routine su questioni strettamente tecniche”.

“Claude è utilizzato per un’ampia varietà di casi d’uso legati all’intelligence in ambito governativo, incluso il Dipartimento della Guerra, in linea con la nostra Politica di Utilizzo” ha aggiunto.

Il portavoce ha inoltre precisato che “Le conversazioni di Anthropic con il Dipartimento della Guerra fino ad oggi si sono concentrate su una serie specifica di questioni relative alla Politica di Utilizzo, ovvero i nostri limiti rigorosi in materia di armi completamente autonome e sorveglianza interna di massa, nessuno dei quali riguarda le operazioni attuali”.

Nonostante le tensioni e le divergenze sulle condizioni di utilizzo, Anthropic ribadisce la volontà di restare attiva nel settore della sicurezza nazionale. Il portavoce ha dichiarato che l’azienda è ancora impegnata in quest’area: “Ecco perché siamo stati la prima azienda di intelligenza artificiale all’avanguardia a inserire i nostri modelli su reti classificate e la prima a fornire modelli personalizzati per i clienti della sicurezza nazionale.”

A RISCHIO IL CONTRATTO DA 200 MILIONI CON IL DOD

Pensare che proprio lo scorso giugno la stessa Anthropic aveva comunicato con soddisfazione l‘aggiudicazione del contratto da 200 milioni di dollari al Pentagono per accelerare l’adozione dell’intelligenza artificiale da parte delle forze armate. La stessa società lo aveva definito “un nuovo capitolo nell’impegno di Anthropic a sostegno della sicurezza nazionale degli Stati Uniti”.

In quell’occasione lo Chief Digital and Artificial Intelligence Office (CDAO), che definisce gli standard di intelligenza artificiale per il Dipartimento della Difesa, aveva annunciato l’assegnazione di contratti ad Anthropic, Google, OpenAI e l’azienda di intelligenza artificiale di Elon Musk fino a 200 milioni di dollari ciascuno. I contratti rappresentano un flusso di entrate significativo per le aziende di IA, che cercano di espandere la propria presenza nel settore pubblico, secondo Bloomberg. Secondo Axios, l’iniziativa rientra nell’adozione da parte del Pentagono di capacità avanzate di intelligenza artificiale per affrontare le sfide della sicurezza nazionale.

E ora proprio questo contratto con il Dod è a rischio per Anthropic: “Tutto è sul tavolo”, incluso il ridimensionamento della partnership con Anthropic o la sua completa interruzione, ha affermato il funzionario ad Axios. “Ma dovrà esserci una sostituzione ordinata, se pensiamo che sia la soluzione giusta”.

Inoltre, sempre Axios ricorda che Claude è il primo modello introdotto dal Pentagono nelle sue reti classificate, assumendo un ruolo centrale nell’infrastruttura tecnologica dell’amministrazione per attività sensibili.

Parallelamente, ChatGPT di OpenAI, Gemini di Google e Grok di xAI vengono utilizzati in ambienti non classificati. Secondo quanto riportato, tutti e tre avrebbero accettato di rimuovere le restrizioni applicate agli utenti comuni per il loro lavoro con il Pentagono. Il Pentagono sta negoziando con loro per entrare nel settore classificato e insiste sullo standard “per tutti gli scopi legittimi” sia per gli usi classificati che per quelli non classificati.