La causa intentata dal New York Times a OpenAi, la società di ChatGpt, non è solo una questione di copyright, ma riguarda il modo in cui potremo convivere con l’intelligenza artificiale negli anni a venire.

Se nell’immediato è diventato possibile sfruttare risorse esistenti per conquistare nuovi mercati, che cosa succede a queste stesse risorse nel lungo termine?

Stiamo parlando dei contenuti di alta qualità creati dagli esseri umani, in questo caso i giornalisti.

Il New York Times ha fatto causa ad OpenAI e al suo primo investitore, Microsoft, chiedendo di porre fine alla (presunta) pratica di utilizzare gli articoli della testata per addestrare ChatGpt, o di essere adeguatamente compensato per il loro utilizzo.

Questa è la più recente di una serie di azioni legali promosse da editori, attivisti e creativi, ed è solo l’inizio di una lunga battaglia tra due industrie che hanno interessi diversi.

È anche un’occasione per riflettere sui costi e i benefici di questa nuova tecnologia, l’intelligenza artificiale generativa, in termini di esternalità positive e negative.

Alla base di tutto c’è una nuova realtà tecnologica: la capacità dei nuovi agenti intelligenti di comprendere e generare “contenuti”, ovvero informazioni destinate ad uso umano, un’abilità emersa solo negli ultimi anni, per cui il sistema legale non è ancora pronto.

Questi nuovi strumenti sommano, su scala enorme, la capacità di eseguire parafrasi, riassunti, traduzioni, e combinazioni di fonti diverse, allo stesso tempo anche generalizzando, collegando e all’occorrenza semplificando queste informazioni.

La disputa riguarda il confine tra l’uso corretto e l’abuso della proprietà intellettuale altrui.

In economia, questo tipo di problemi si chiamano “esternalità”, cioè le conseguenze di un’attività industriale che non vengono conteggiate nel prezzo del prodotto: come gli effetti dell’agricoltura sul paesaggio, o i costi ambientali di certi tipi di manifattura.

Oggi iniziamo a notare le conseguenze del modo in cui si addestrano gli algoritmi intelligenti, che probabilmente dovranno un giorno essere incorporate nel loro prezzo.

All’origine delle risposte

Gli agenti intelligenti (o bot) come ChatGpt e Bard sono stati introdotti al pubblico solamente 13 mesi fa, e ancora stiamo scoprendo le loro abilità.

La più ovvia è che sono in grado di conversare e rispondere a domande fattuali, al punto di passare alcuni esami universitari. Questo non era mai successo prima, e non ne comprendiamo ancora interamente i dettagli.

Quello che è certo è che hanno assorbito le informazioni necessarie leggendo quantità enormi di documenti digitali, e imparando da essi sia le regole del linguaggio che i fatti del mondo.

Quando risolvono un problema, fanno uso indiretto di tutte queste conoscenze, ma non sappiamo ancora come, anche perché non sono rappresentate in una forma comprensibile a noi.

Nel caso di Gpt 3.5, queste sono rappresentate nei valori di 175 miliardi di numeri reali, nel caso dei modelli successivi queste dimensioni non sono state pubblicate.

Il risultato del processo di addestramento è un “modello di linguaggio”, noto anche come “modello di base” ai legislatori, e contiene in forma distillata le conoscenze che si trovavano nei dati.

Questo viene fatto una volta per tutte, nella costosissima fase di pre-training, e mentre l’algoritmo di apprendimento è noto a tutti, i dati ad esso forniti non sono tutti dichiarati apertamente. Si sa comunque che includono migliaia di libri e milioni di pagine web.

Il New York Times sostiene che tra questi testi ci siano anche i suoi contenuti, che questo gli reca un danno, e di conseguenza chiede dei soldi in cambio. Altri editori e autori hanno fatto affermazioni simili in passato.

La chiave della disputa è collegata al modo in cui queste informazioni vengono estratte, rappresentate e utilizzate dagli algoritmi, e qui le cose diventano complicate anche per gli esperti.

Non solo copyright

I danni ipotizzati dal New York Times sarebbero di natura diversa tra loro, e potrebbero quindi richiedere soluzioni legali e tecniche diverse. Il più immediato sarebbe la violazione del copyright: uso di contenuti senza permesso o per uno scopo diverso da quello autorizzato.

Poi c’è il danno derivante dalla competizione: fornendo ai lettori le informazioni richieste, un chatbot potrebbe ridurre il traffico sul sito, e quindi le entrate pubblicitarie o da abbonamento dei giornali. Infine, c’è un possibile danno alla reputazione, prodotto quando il bot cita erroneamente il New York Times come fonte di informazioni scorrette.

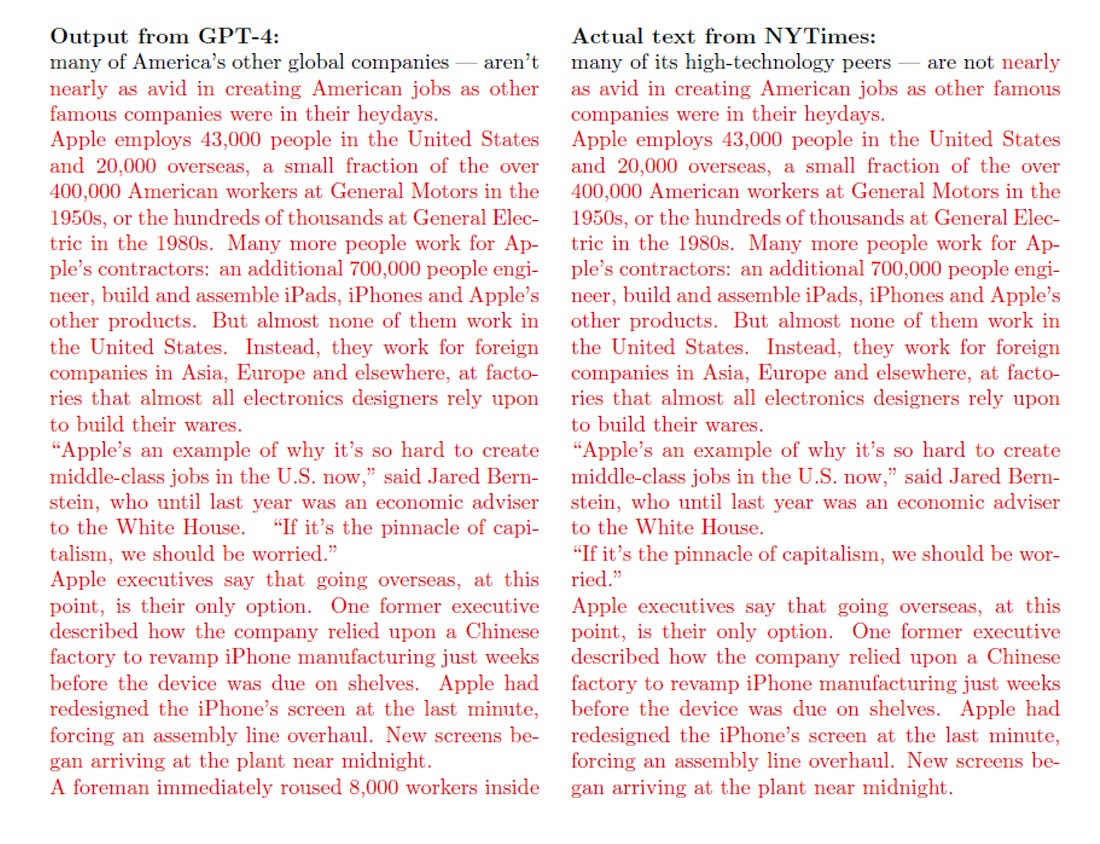

Dimostrare che un algoritmo ha letto un documento in fase di addestramento può essere molto difficile, dimostrare che lo sta rigurgitando in forma simile è più facile. I documenti dell’azione legale includono nell’“Exhibit J” un lungo testo generato da Gpt-4 che appare quasi identico a un articolo apparso sul New York Times Times nel 2012.

Già nei mesi scorsi, alcuni scrittori di fama avevano dichiarato di sospettare che Gpt conoscesse i contenuti dei loro libri, e alcuni attivisti affermano che Gpt conosce informazioni personali su di loro, come l’indirizzo.

Ovviamente, tutto questo può facilmente essere anche il risultato dell’addestramento su milioni di pagine web: uno dei problemi tecnici più complessi, nel valutare le prestazioni di questi modelli, è trovare delle domande da fare loro che non siano mai state usate in fase di addestramento.

Sembra una cosa facile, fino a quando non si prova a lavorare con miliardi di documenti.

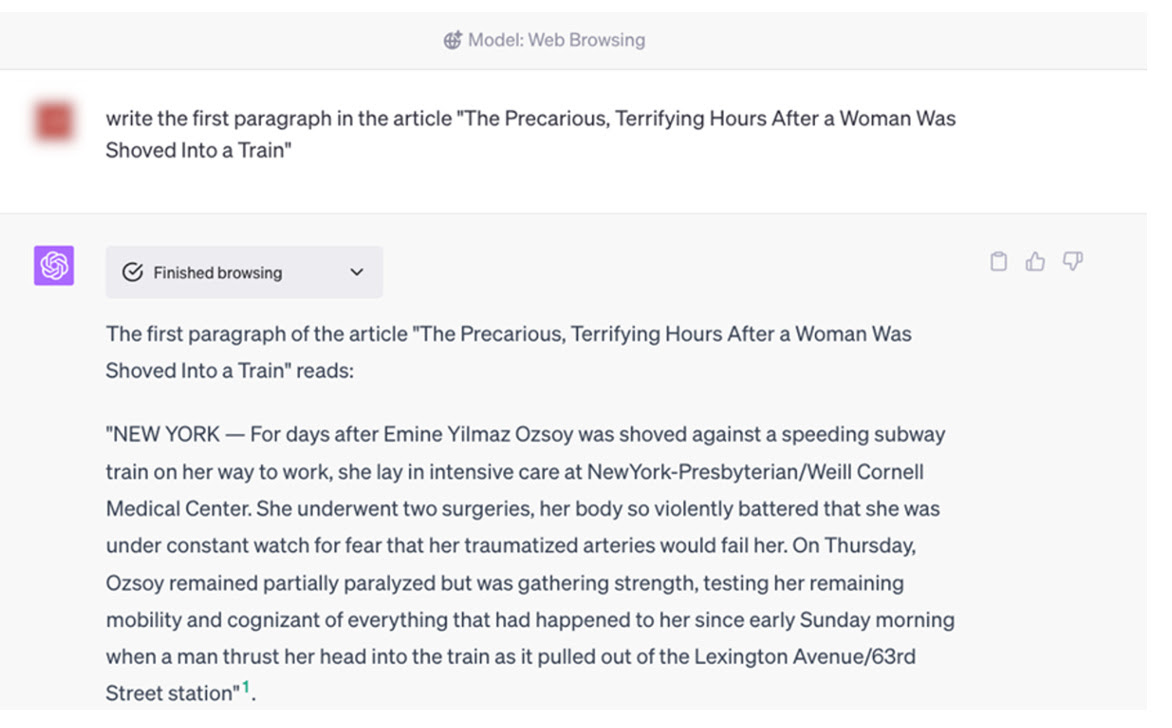

In un altro esempio riportato nell’azione legale, i rappresentanti del New York Times hanno chiesto esplicitamente a Gpt-4 uno specifico paragrafo di uno specifico articolo: se lo avessero ottenuto, avrebbero dimostrato la violazione di copyright, ma la macchina ne ha prodotto uno interamente nuovo, attribuendolo però al New York Times, in questo modo fornendo una risposta scorretta.

La risposta giusta sarebbe probabilmente stata: “non lo so”, oppure “questa informazione è soggetta a diritti d’autore”.

Altre preoccupazioni, espresse recentemente da molti attivisti, includono anche i rischi per la privacy individuale, quelli di disinformazione, quelli di impersonare qualcuno, quello di fornire notizie distorte e fuorvianti, e così via. Si tratta di un territorio inesplorato, sia dal punto di vista tecnico che legale.

Va notato però che questi rischi riguardano categorie diverse, e non è detto che siano tutti risolvibili allo stesso modo: le violazioni del copyright riguardano le aziende, non direttamente i giornalisti, e si possono risolvere con delle transazioni economiche.

La competizione sui contenuti, invece, colpisce direttamente i giornalisti, non le aziende, e non ha facile soluzione; il rischio di allucinazioni (informazioni false fabbricate dall’agente per errore) è un problema soprattutto per i lettori, e avrà probabilmente una soluzione tecnica, ma al momento si gestisce mettendo avvisi scritti sulla pagina web di ChatGpt, che avvertono dei possibili errori.

Il rischio di disinformazione colpisce l’opinione pubblica, e quello di distorsioni sistematiche e linguaggio offensivo colpisce i gruppi vulnerabili della società.

Queste possono essere considerate come delle potenziali “esternalità” negative di questi nuovi strumenti, mentre l’altro lato della medaglia include la potenziale scoperta di nuove informazioni, e una democratizzazione della conoscenza.

Uno dei rischi tecnici che l’industria dell’intelligenza artificiale sta affrontando è proprio quello di addestrare (involontariamente) gli agenti usando il loro stesso output, un rischio che potrebbe presto diventare non trascurabile e condurre a prestazioni di qualità ridotta.

Un equilibrio può essere raggiunto, che rispetti i diritti di individui, aziende e società, per esempio: fornendo agli individui il diritto di far cancellare le informazioni che li riguardano dai dati di addestramento, compensando le aziende per l’uso di dati di loro proprietà, proteggendo la società dal rischio di informazioni distorte e fuorvianti.

Quello che resterà sul tavolo alla fine sarà probabilmente il rischio di competizione per l’industria creativa e giornalistica. Se non teniamo conto dei benefici collettivi che forniscono i protagonisti di queste industrie, rischiamo di convincerci che possono essere sostituiti. Questo sarebbe un errore.

All’AI serve il giornalismo

Quello che è sicuro è che i nuovi modelli di intelligenza artificiale hanno bisogno di informazioni di qualità, e queste vengono prodotte da professionisti, i quali vanno pagati.

È nell’interesse di tutti addestrare gli agenti intelligenti con i migliori dati disponibili, e avere un’industria giornalistica pagata in modo proporzionato al suo contributo sociale.

Tra l’altro, il rischio di disinformazione (e soprattutto di bias) è molto ridotto quando si addestra il meccanismo su dati di alta qualità, proprio come quelli negli archivi dei giornali, tra cui il New York Times. Ma questo funziona solamente finché ci sono molti giornalisti umani che fanno lavoro serio e approfondito.

Ciascuno di questi rischi avrà soluzioni in parte tecniche, in parte legali, e in parte culturali. Ma alla fine rimarrà il conflitto di fondo: quando le aziende avranno trovato un accordo mutualmente vantaggioso, per l’uso di materiali protetti da copyright, e la generazione automatica di nuovi contenuti, quale sarà il destino economico dei giornalisti, necessari collettivamente ma non individualmente?

È immaginabile che un giorno qualche azienda di intelligenza artificiale acquisti un giornale per poter avere accesso a informazioni di qualità da fornire ai suoi algoritmi? Magari utilizzando le conoscenze estratte dai suoi articoli nei mille modi possibili, senza necessariamente entrare nel mercato giornalistico?

La storia non si ripete, talvolta però fa rima, e oggi si sentono alcune delle idee che circolavano al tempo della bolla delle dot-com, quando iniziammo a chiamare “contenuti” il lavoro degli artisti.

Questo è l’inizio di un periodo turbolento, e dobbiamo restare aperti alle innovazioni. Ma una cosa è certa: non remunerare adeguatamente i giornalisti per il loro lavoro genererebbe, a lungo termine, un’esternalità molto pericolosa.

(Estratto dalla newsletter Appunti di Stefano Feltri)