Il rispetto della privacy sta diventando un punto cruciale che, insieme alla gestione dei diritti d’autore, può cambiare le sorti dell’intelligenza artificiale. L’Artificial Intelligence Act, il Regolamento europeo sull’intelligenza artificiale, non se ne occupa, ma rinvia al GDPR (Reg. EU 679/2016 sul trattamento dei dati personali), ribadendo che chi sviluppa o utilizza sistemi di intelligenza artificiale deve rispettare quella normativa, oltre che molte altre.

In pratica, però, il rispetto del GDPR è cosa complessa.

Il Regolamento europeo sulla privacy prevede una serie di obblighi in capo a chi tratta dati personali tra cui, uno dei più importanti, riguarda il dovere di fornire l’informativa sull’uso dei dati e sui diritti degli interessati, incluso il diritto di opporsi al trattamento.

Inoltre, perché possano essere trattati dati in modo lecito, deve esistere una base giuridica, che può essere ravvisata nel contratto, nell’interesse legittimo, nell’obbligo di legge o nel consenso dell’interessato.

Nei primi tre casi non occorre il consenso dell’interessato, in quanto chi tratta i dati fa per potere adempiere a un contratto che ha stipulato con la persona fisica, perché il trattamento gli è imposto dalla legge, ad esempio per fini fiscali, o perché esercita un suo interesse legittimo prevalente rispetto ai diritti dell’interessato.

L’interpretazione dell’interesse legittimo è spesso difficile e troppe volte viene invocato in modo infondato. In sostanza esso sussiste quando, in base ai rapporti che intercorrono tra la persona fisica e chi tratta i suoi dati, è legittimo attendersi un certo utilizzo degli stessi, come nel caso di uno studio professionale che invia comunicazioni informative, e non commerciali, ai propri clienti per aggiornarli su certi adempimenti in scadenza.

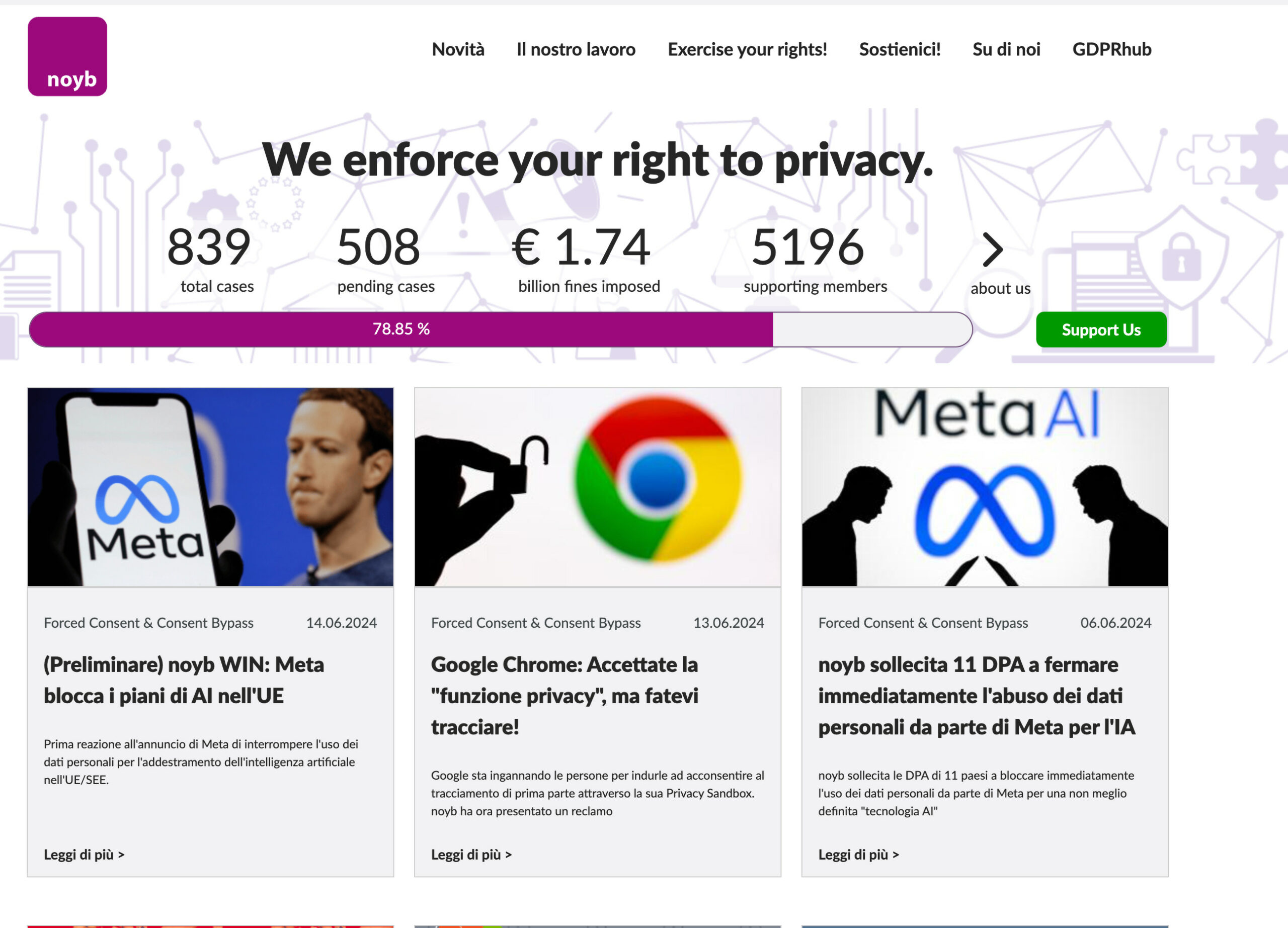

Proprio l’interesse legittimo, invocato da Meta nella sua informativa, è al centro di una nuova battaglia legale promossa dall’associazione NOYB, European Center for Digital Rights, che fa capo a Max Schrems, l’attivista austriaco che aveva già intentato numerose azioni contro diverse società, facendo saltare l’accordo sul Privacy Shield che consentiva lo scambio di dati tra Europa e Stati Uniti.

Con i nostri dati

NOYB ha recentemente presentato un ricorso di fronte a undici Garanti della privacy in Europa, tra cui l’Italia, per chiedere che venga impedita l’adozione di AI Meta, annunciata per imminente, con cui Mark Zuckerberg intende integrare nei suoi servizi sistemi di intelligenza artificiale.

Meta AI, si legge sul sito ufficiale, è un assistente intelligente, basato su Meta Llama 3, “capace di ragionamenti complessi, di seguire istruzioni, di visualizzare idee e di risolvere problemi”, oggi disponibile solo in alcuni paesi selezionati.

In Europa non è disponibile perché Meta ha deciso di metterlo in pausa, dopo che ha seguito dei ricorsi di NOYB, in Irlanda e nel Regno Unito, i Garanti hanno chiesto a Meta di sospendere il progetto che non prevede solo la fornitura del servizio Meta AI, ma anche l’utilizzo dei dati di Facebook e Instagram per addestrare il sistema di intelligenza artificiale.

Una delle questioni della discordia sono le nuove condizioni privacy di Meta, rese note agli inizi di questo mese, che dovrebbero entrare in vigore dal 26 Giugno, in cui si evidenzia che i dati pubblici degli utenti che utilizzano i suoi servizi saranno utilizzati anche per l’addestramento di sistemi di intelligenza artificiale, senza bisogno del consenso degli interessati, ma sulla base dell’interesse legittimo di Meta.

La nuova politica, che riguarderebbe circa quattro miliardi di utenti, consentirebbe a Meta di utilizzare i dati degli utenti, dal 2007 in poi, con l’unica eccezione delle chat private, nei sistemi di intelligenza artificiale, senza specificare in modo chiaro il fine di questo utilizzo.

In un’intervista Max Schrems ha dichiarato che una definizione del genere è inaccettabile, in quanto Meta deve indicare espressamente l’uso che ne farà e non limitarsi a indicare con quale tecnologia saranno trattati.

La questione è molto complessa, sia dal punto di vista giuridico che dal punto di vista pratico.

Si può senz’altro discutere della correttezza o meno di un’informativa, ma è assai difficile a livello pratico dimostrare che un sistema di intelligenza artificiale è addestrato sulla base dei dati personali di qualcuno in particolare.

Nessuno conosce esattamente i dati di addestramento e quando finiscono nella massa dei dati da cui vengono estratti, più che singole informazioni, modelli matematici, essi vengono talmente macinati e digeriti da disperdersi nel processo.

Dal punto di vista pratico, la situazione è ancora più critica, in quanto i dati utilizzati sono talmente numerosi e raccolti in modo indiscriminato, che non è possibile selezionare all’interno di essi dati generici, personali, sensibili o particolari, per cui se si ravvisasse un illecito si rischierebbe di dovere impedire la raccolta di dati tout court. Problema, per certi versi, simile a quello che si pone in merito ai dati coperti da diritto d’autore.

Cosa dice l’ufficio del Garante

Nell’attesa di conoscere la posizione italiana sul punto, e con tutti i limiti dovuti al segreto istruttorio, ne abbiamo parlato con l’avvocato Guido Scorza, componente del Collegio del Garante della Privacy, e uno dei massimi esperti della materia.

Avvocato Guido Scorza, il suo ufficio è stato il primo a ravvisare nell’intelligenza artificiale uno strumento che può mettere al rischio il rispetto della privacy.

La vostra decisione nei confronti di ChatGPT del 30 marzo 2023 ha fatto discutere, ma poi è diventata un modello per altri uffici.

Oggi vi trovate nuovamente di fronte al rapporto tra intelligenza artificiale e privacy. Cosa hanno di diverso i due casi?

La questione di fondo è comune e riguarda le condizioni in presenza delle quali un soggetto può trattare i dati personali di centinaia di milioni di persone in Europa e miliardi nel mondo per addestrare i propri algoritmi.

Si tratta di una questione, peraltro, che riguarda la totalità delle “fabbriche di intelligenza artificiale generativa” e non solo OpenAI e Meta.

Direi che una delle differenze principali tra le due vicende sta nel fatto che nella prima, OpenAI, in assenza di qualsiasi precedente, aveva, sostanzialmente ignorato ogni questione connessa all’applicazione della disciplina europea sulla privacy mentre nella seconda Meta ha potuto far tesoro di quanto emerso nell’ambito della prima vicenda e ha, dunque, cercato una serie di soluzioni finalizzate a contemperare le proprie esigenze di business con le regole sulla privacy.

Che la società di Zuckerberg ci sia riuscita è qualcosa che occorrerà valutare nel corso dell’istruttoria pendente e su cui, pertanto, non posso dire nulla.

Certo Meta ha il vantaggio – almeno in relazione al trattamento dei dati raccolti all’interno delle proprie properties digitali – di “conoscere” gli interessati e di avere, almeno, potuto loro presentare una specifica informativa.

Max Schrems, nel suo ricorso, richiama la decisione della Corte di Giustizia (C-252/21) per affermare che l’interesse legittimo non può essere una base giuridica adeguata per il trattamento dei dati. Lei cosa ne pensa?

Basterà una revisione dell’informativa o ci troviamo di fronte a un problema più complesso?

Sul caso specifico, come detto, non posso pronunciarmi. In generale, tuttavia, escluderei che la questione della legittimità o meno del ricorso al legittimo interesse per l’addestramento degli algoritmi possa esaurirsi e risolversi con un aggiornamento di un’informativa.

È molto più complessa e attiene, innanzitutto, alla valutazione comparativa tra l’interesse – credo di poter dire indiscutibile e indiscutibilmente legittimo di Meta – e il sacrificio in termini di diritti e interessi delle centinaia di milioni di interessati europei delle sue piattaforme. Davvero il primo prevale sui secondi?

C’è, peraltro, in ogni caso, il problema dei dati particolari che in nessun caso possono essere trattati sulla base del legittimo interesse.

E anche qualora si voglia concludere in senso affermativo, poi, gli interessati possono contare sull’effettiva esercitabilità dei diritti – a cominciare dal diritto di opposizione – che il GDPR riconosce loro? Dubitarne è certamente lecito.

Meta ha previsto che gli utenti possano esercitare un diritto di opt-out relativo all’utilizzo dei propri dati personali. È un meccanismo che può funzionare?

In principio è quanto prevede la disciplina europea laddove un trattamento di dati personali sia stato validamente avviato sulla base del legittimo interesse.

Nello specifico, volendo e dovendo evitare di parlare del caso concreto, credo si debbano considerare due profili: il primo è che il riconoscimento del diritto di opposizione, qualora si dovesse ritenere la base giuridica del legittimo interesse inadeguata, è, ovviamente, inidoneo a sanare la violazione e il secondo è che, nel corso dell’istruttoria, andranno necessariamente valutate l’effettività e l’ampiezza del diritto di opposizione che Meta riconosce agli interessati.

Meta sostiene di non essere in grado di distinguere i dati che usa per l’addestramento e quindi di non potere separare i dati di libero utilizzo da quelli coperti da diritti o i dati personali, generali o particolari.

Se si impedisce a Meta di utilizzare dati personali non c’è il rischio di bloccare lo sviluppo dei sistemi di intelligenza artificiale? Quale soluzione vede possibile, anche “de iure condendo”?

Certamente sì, il rischio è concreto in relazione al caso Meta, così come in relazione al caso OpenAI e, naturalmente, a tutti gli altri analoghi trattamenti in corso.

In tutta onestà io credo che la questione non possa essere risolta dalle autorità di protezione dei dati personali europee semplicemente interpretando e applicando le regole vigenti ma avrebbe richiesto e continui a richiedere un intervento di natura legislativa.

C’è da assumere una scelta politica. Le soluzioni, in una prospettiva de iure condendo, possono essere diverse.

Personalmente, se vi fosse la volontà di affrontare la questione a livello legislativo, valuterei la possibilità di considerare l’addestramento degli algoritmi – e, quindi, i trattamenti correlati a tale attività – come di interesse pubblico, probabilmente, associando una simile dichiarazione a un sistema di limiti e condizioni, incluso un meccanismo di licenze obbligatorie e/o altre analoghe soluzioni di distribuzione di benefici, vantaggi e ricchezza perché mi pare difficilmente accettabile l’idea di considerare di interesse pubblico tout court un’attività che arricchisce pochi e accresce oligopoli già esistenti senza riconoscere alcunché alle persone i cui dati personali sono utilizzati e alla società nel suo complesso.

Purtroppo né l’AI Act, né il disegno di legge italiano sull’intelligenza artificiale in discussione al Senato, si occupano di questo problema e non prevedono soluzioni.

Attendiamo di leggere la decisione del Garante che potrebbe, ancora una volta, riservarci sorprese e suggerire correttivi.

(Estratto dalla newsletter Appunti di Stefano Feltri: ci si iscrive qui)