A metà febbraio si è parlato di un articolo scientifico palesemente scritto con ChatGpt che – incredibilmente – è arrivato addirittura a essere pubblicato nonostante le castronerie presenti. Ora, un recente studio ha dimostrato come l’uso di chatbot di intelligenza artificiale e, in particolare di quello di OpenAI, stiano inquinando non solo la stesura degli articoli stessi ma anche la peer-review, ovvero la revisione di ricercatori terzi e indipendenti che dovrebbe valutare l’attendibilità di una ricerca prima della sua pubblicazione.

AGGETTIVI “SOSPETTI”

Lo studio, pubblicato su arXiv in pre-print e, dunque, a sua volta non ancora sottoposto a peer-review, ha individuato alcune parole tipiche di un testo generato dall’intelligenza artificiale (IA) che rivelerebbero l’uso di chatbot nel processo di revisione. Tra queste, gli autori hanno segnalato aggettivi positivi come “lodevole”, “innovativo”, “meticoloso”, “intricato”, “notevole” e “versatile”.

In particolare, analizzando oltre 146.000 revisioni tra pari, secondo i ricercatori tra il 6,5% e il 16,9% dei testi “potrebbe essere stato modificato in modo sostanziale dai modelli linguistici di grandi dimensioni (LLM), vale a dire al di là del controllo ortografico o di piccoli aggiornamenti di scrittura”.

Non è chiaro se i ricercatori abbiano usato gli strumenti per costruire le loro recensioni da zero o solo per modificare e migliorare le bozze scritte, ma per l’informatico dell’Università di Stanford (California) e coautore dello studio Weixin Liang “sembra che quando le persone non hanno tempo tendano a usare ChatGpt”. Non a caso gli aggettivi rivelatori sono stati rintracciati più spesso nelle recensioni inviate a ridosso della scadenza.

LA DERIVA DELLA RICERCA POST CHATGPT

Dal suo rilascio nel novembre 2022, “ChatGpt è stato utilizzato per scrivere numerosi articoli scientifici, in alcuni casi anche come autore”, afferma Nature. Degli oltre 1.600 scienziati che hanno risposto a un sondaggio della rivista scientifica del 2023, quasi il 30% ha dichiarato di aver utilizzato l’IA generativa per scrivere articoli e circa il 15% ha dichiarato di averla usata per le proprie revisioni della letteratura e per scrivere domande di sovvenzione.

Per Debora Weber-Wulff, informatica presso l’HTW Berlin-University of Applied Sciences della Germania, l’idea che i chatbot scrivano rapporti di referaggio per lavori non pubblicati è “molto scioccante”, dato che questi strumenti spesso generano informazioni fuorvianti o falsificate: “I sistemi di intelligenza artificiale hanno le ‘allucinazioni’ e non possiamo sapere quando sono allucinate e quando no”.

Lo studio ha ispirato anche altre ricerche, come quella di Andrew Gray, funzionario di supporto alla bibliometria presso l’University College London, il quale, analizzando quante volte ricorrevano gli stessi aggettivi negli studi sottoposti a peer-review e pubblicati tra il 2015 e il 2023, ha osservato un loro “un aumento significativo” dall’arrivo di ChatGpt. La ricerca stima inoltre che gli autori di almeno 60.000 articoli pubblicati nel 2023 – poco più dell’1% di tutti gli studi accademici pubblicati in quell’anno – hanno utilizzato in qualche misura i chatbot.

E secondo Nature, il 2023 è stato l’anno con il maggior numero di articoli scientifici – oltre 10mila – ritirati dalle riviste che li avevano pubblicati a causa di dati inventati, immagini già pubblicate e testi generati con l’IA.

LO STUDIO GENERATO DALL’IA E PUBBLICATO SU UNA RIVISTA SCIENTIFICA

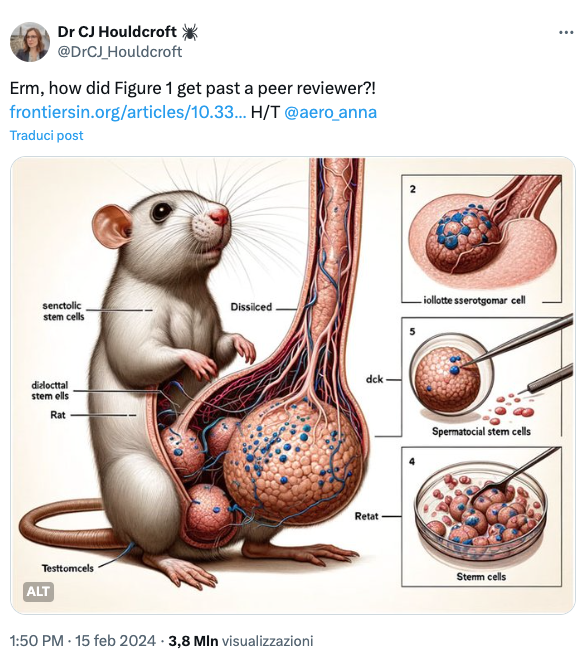

A proposito di IA che si insinua nella ricerca accademica, lo scorso febbraio si è verificato un episodio alquanto eclatante. La rivista scientifica Frontiers in Cell and Developmental Biology ha infatti pubblicato una ricerca sulle cellule staminali nei piccoli mammiferi con errori testuali e immagini assurde senza che nemmeno i ricercatori selezionati per la peer review si accorgessero di nulla. Ratti su due zampe, con quattro testicoli e un pene decisamente sproporzionato, parole senza senso e didascalie al limite della volgarità.

Leggerezze abbastanza evidenti che hanno suscitato un acceso dibattito sui social e tra gli accademici, che ha infine costretto la rivista a ritirare l’articolo. Secondo alcuni esperti, questa tendenza è dovuta al fatto che la ricerca è sempre più dipendente da un sistema di incentivi economici che premia autori ed editori per la quantità di pubblicazioni scientifiche, il che si ripercuote inevitabilmente sulla qualità.

Come ha osservato la microbiologa olandese Elisabeth Bik, che si occupa di integrità della ricerca su Science Integrity Digest, questo è solo “un triste esempio di come riviste scientifiche, editori e revisori tra pari possano essere ingenui – o forse addirittura coinvolti nel giro – in termini di accettazione e pubblicazione di schifezze generate dall’intelligenza artificiale”. E se un simile caso è riuscito a superare anche la revisione, per Bik, “immagini con un aspetto più realistico, generate dall’intelligenza artificiale, probabilmente si sono già insinuate nella letteratura scientifica”.