Nei giorni scorsi la notizia che ha catturato l’attenzione dei media, anche perché aggiunge molta benzina sul fuoco per chi pensa che l’AI sia più pericolosa che utile, sono state le dimissioni di Geoffrey Hinton da Google.

Chi è Geoffrey Hinton

Geoffrey Everest Hinton, spesso definito il “padrino del deep learning”, è una figura pionieristica nel campo dell’intelligenza artificiale. Nasce a Londra nel 1947 da una famiglia di scienziati e ricercatori: il suo secondo nome è in onore di un lontano parente, George Everest, a cui fu intitolata la montagna più alta del mondo. Il bisnonno era George Boole, il fondatore della logica matematica e dell’algebra booleana. Hinton ha avuto una lunga carriera nello sviluppo di tecniche di intelligenza artificiale all’avanguardia. Come psicologo cognitivo e ricercatore informatico il suo lavoro è stato determinante nel plasmare il panorama moderno dell’intelligenza artificiale, in particolare nel campo delle reti neurali e del deep learning.

L’impatto di Hinton sull’intelligenza artificiale è dovuto soprattutto al suo lavoro sulla backpropagation o retropropagazione, una tecnica di apprendimento che aiuta le reti neurali a migliorare le loro previsioni regolando iterativamente le connessioni tra i neuroni in base agli errori commessi. Questo processo permette alla rete di “imparare” dai suoi errori e di diventare più precisa nelle sue previsioni. Sviluppato in collaborazione con David Rumelhart e Ronald J. Williams negli anni ’80, la backpropagation è diventata una pietra miliare del machine learning moderno, gettando inoltre le basi per il deep learning, un’innovazione che ha portato le capacità dell’AI a livelli mai raggiunti prima. Il deep learning prevede l’addestramento di reti neurali artificiali con molti strati, consentendo alle macchine di riconoscere modelli complessi e prendere decisioni “intelligenti” sulla base di grandi quantità di dati.

Il lavoro innovativo di Hinton nel campo del deep learning è stato ulteriormente confermato quando il suo team dell’Università di Toronto ha vinto con un margine significativo l’ImageNet Large Scale Visual Recognition Challenge (ILSVRC) del 2012. Questa competizione annuale, che prevede la classificazione di milioni di immagini in migliaia di categorie, è stata storicamente un compito impegnativo per i sistemi di visione artificiale. Il team di Hinton, tuttavia, ha utilizzato una rete neurale convoluzionale profonda chiamata AlexNet, che ha migliorato notevolmente la precisione del riconoscimento delle immagini e ha superato altri metodi concorrenti. Questo risultato epocale ha accelerato l’interesse e gli investimenti nel deep learning, cementando l’eredità di Hinton come titano nel campo dell’AI.

In riconoscimento dei suoi monumentali contributi al campo dell’intelligenza artificiale, nel 2018 Geoffrey Hinton è stato insignito del prestigioso Premio Turing, insieme ai colleghi pionieri del deep learning Yann LeCun e Yoshua Bengio. Spesso definito il “Premio Nobel dell’informatica”, il Premio Turing viene conferito dall’Association for Computing Machinery (ACM) a persone che hanno dato contributi significativi e duraturi al campo dell’informatica. Hinton, LeCun e Bengio sono stati premiati insieme per il loro lavoro sul deep learning, parte integrante del progresso nella percezione artificiale e nella comprensione del linguaggio naturale. Il premio non solo ha evidenziato l’impatto trasformativo della ricerca di Hinton, ma è stato anche un riconoscimento del ruolo sempre più importante che l’AI svolge nel plasmare il mondo moderno.

Perché Hinton si trovava in Google?

La storia è ben raccontata da Cade Metz nel suo libro Costruire l’intelligenza. Google, Facebook, Musk e la sfida del futuro (qui in inglese). Come già scritto, nel 2012 un team della University of Toronto composto da Alex Krizhevsky, Ilya Sutskever e Geoffrey Hinton vinse la competizione ImageNet 2012 grazie alla loro rete neurale convoluzionale. Fu l’evento che portò nuovamente all’attenzione della più ampia comunità di ricerca i metodi basati sulle reti neurali, largamente ignorati (se non proprio ridicolizzati) fino a poco tempo prima.

Hinton e il suo piccolo team iniziarono subito a essere corteggiati da grandi aziende, ma invece di cedere alle lusinghe di un posto di lavoro ben pagato, i tre compresero che il modo migliore per massimizzare i frutti del loro lavoro sarebbe stato creare una società che contenesse al suo interno, oltre ovviamente ai tre ricercatori, anche la proprietà intellettuale della ricerca. Nacque così DNNresearch, una start-up fatta di tre persone e una rivoluzione tecnologica.

A questo seguì un’asta svolta via e-mail in pochi giorni e a cui parteciparono, narra la storia, Baidu, Google, Microsoft e DeepMind (che ancora non faceva parte di Google). Dopo una serie di rialzi e colpi di scena narrati nel libro, alla fine la spuntò Google con 44 milioni di dollari. Le offerte avrebbero potuto crescere ancora, ma Hinton sorprese tutti decidendo di chiudere l’asta a 44 milioni e dare la vittoria a Google. Le ragioni del gesto erano molteplici, anzitutto perché i tre ritenevano che Google fosse un luogo giusto dove proseguire la ricerca, ma oltre a questo si pensa che Hinton avrebbe mal sopportato di trasferirsi in Cina se avesse vinto Baidu, visto i problemi cronici alla schiena che gli impediscono di sedersi (rendendo i viaggi in aereo praticamente impossibili).

Nel marzo del 2013 Hinton, Krizhevsky e Sutskever finirono quindi a Google, dove Sutskever restò fino al 2015 per poi dimettersi e fondare OpenAI (dove ancora oggi è a capo della ricerca), Krizhevsky restò fino al 2017 e Hinton fino a pochi giorni fa.

Cosa ha detto Hinton nel corso di questi anni

Una delle affermazioni più controverse, e che successivamente ha costretto il ricercatore a una parziale marcia indietro, venne pronunciata nel 2016 durante la Machine Learning and Market for Intelligence Conference a Toronto e disponibile su YouTube: “Vorrei iniziare dicendo alcune cose che mi sembrano ovvie. Penso che se siete radiologi, fate come il coyote (si riferisce al personaggio Wile E. Coyote dei vecchi cartoni di Looney Tunes, n.d.T) che ha già superato il bordo del precipizio ma che non ha ancora guardato giù, quindi non sa che non c’è terra sotto di lui. Si dovrebbe smettere di formare i radiologi. È del tutto ovvio che entro 5 anni il deep learning farà meglio dei radiologi, perché sarà in grado di acquisire molta più esperienza. Potrebbero volerci 10 anni, ma abbiamo già un sacco di radiologi.”

Hinton si corresse parzialmente l’anno dopo in un’intervista a The New Yorker: “Il ruolo dei radiologi si evolverà dal fare cose percettive, che potrebbero essere fatte da un piccione altamente addestrato, a fare cose molto più cognitive.” Quindi in uno scambio di e-mail con la testata Politico, nel 2022, arrivò un’altra parziale correzione, dove Hinton affermò che non aveva mai suggerito di rimpiazzare i radiologi, bensì di lasciare che fosse l’AI a leggere le radiografie al posto loro, e in un’intervista a CBS nel marzo 2023 aggiustò ulteriormente il tiro, affermando che forse avremo bisogno semplicemente di meno radiologi, oppure dello stesso numero di radiologi ma con un deciso incremento della loro produttività.

Ma per capire meglio l’Hinton-pensiero, al netto del sarcasmo che fa sempre parte delle sue uscite, è utile leggere un’intervista di dodici anni fa, quando ancora non era diventato famoso per il deep learning, che mostra come sia sempre stato conscio che non è la tecnologia a essere intrinsecamente benevola o malvagia, bensì la politica sottostante che ne fa uso: “I bancomat sono meglio dei dipendenti di sportello se si vuole eseguire una semplice transazione. Sono più veloci, danno meno problemi e sono più affidabili, quindi tolgono il lavoro a chi si trova allo sportello bancario. Ora, se questo sia un bene o un male dipende da ciò che accadrà in seguito. Potenzialmente dovrebbe essere una cosa positiva in una società che si prende cura delle persone. Rendere tutto più efficiente dovrebbe fare tutti più felici. Ma se invece non fa altro che rendere alcuni banchieri estremamente ricchi e lasciare senza lavoro molti poveri, non è una buona cosa, quindi si tratta di una questione politica che riguarda il modo in cui viene utilizzata.”

Perché Hinton si è dimesso da Google?

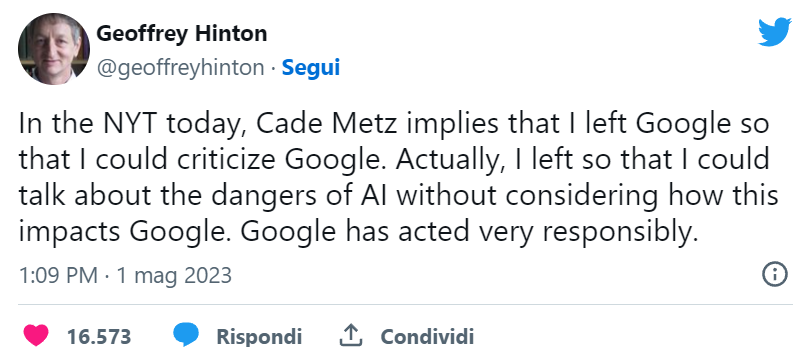

Arriviamo dunque alle sue dimissioni da Google che, come ha puntualizzato lo stesso Hinton su Twitter, non sono in polemica con l’azienda, che si sarebbe “comportata in maniera molto responsabile”.

Il primo a dare la notizia è stato Cade Metz, l’autore del libro citato precedentemente, dalle colonne del New York Times. Il motivo menzionato nell’articolo è stato quello di poter parlare più liberamente dei rischi dell’intelligenza artificiale.

Durante EmTech Digital, in cui Hinton ha fatto la sua prima uscita pubblica dopo le dimissioni da Google, il ricercatore ha argomentato meglio la sua decisione. Il primo motivo è legato alla sua età, poiché a 75 anni non si sente più in grado di svolgere compiti di ricerca tecnologica, di conseguenza “è il momento di andare in pensione“, come Hinton ha candidamente ammesso. Il secondo motivo, probabilmente più importante, è l’aver cambiato completamente opinione sul rapporto fra cervello umano e tecnologia AI. Fino a poco tempo fa, e nonostante le baldanzose prese di posizione del passato, Hinton riteneva che i modelli di intelligenza artificiale non sarebbero mai stati al livello del cervello umano. La ricerca AI secondo lui era un modo per fare nuove scoperte su come potesse funzionare il nostro cervello.

Ora, invece, Hinton si è reso conto che AI e cervello umano probabilmente non funzionano in modi paragonabili, e che quindi non sia utile fare ricerca sulle reti neurali per comprendere meglio come funziona il cervello. Ma oltre a realizzare che le fondamentali differenze fra AI e cervello umano non permettono un confronto scientificamente significativo, Hinton ha anche compreso che le tecniche usate dalle moderne tecnologie di intelligenza artificiale sono “molto meglio” delle tecniche usate dal nostro cervello, ed è qui che Hinton ha iniziato ad aver paura. L’unico modo per parlarne liberamente sarebbe stato dopo aver tagliato i legami con un datore di lavoro impegnato proprio in quel settore, e così ha fatto, lasciando l’azienda che lo assorbì dieci anni prima. La paura dello sviluppo incontrollato dell’intelligenza artificiale è ora forte in Hinton, mentre a suo modo di vedere il problema non viene ancora affrontato come si deve dalla società civile, quindi si è dimesso per avere tutta la libertà – anche intellettuale – di suonare l’allarme.

Perché Hinton ha iniziato ad avere paura dell’AI?

Il ricercatore ha osservato che GPT-4 “sa” molte più cose di quelle che può sapere un essere umano, e possiede una conoscenza “di senso comune” praticamente su tutto. Visto che tali modelli AI sono in grado di arrivare a questi risultati solo con un bilione di connessioni, mentre noi esseri umani sapremmo molte meno cose avendo però a disposizione, nel nostro cervello, centinaia di bilioni di connessioni neurali, ne consegue che le reti neurali moderne siano molto più efficienti nel detenere conoscenza rispetto al cervello umano.

Questa capacità è poi moltiplicata dalla possibilità per una rete neurale di creare innumerevoli copie di sé, dove ognuna aggiorna le altre non appena acquisisce nuove informazioni, consentendo così a tutto il gruppo un apprendimento simultaneo esponenziale, che permette a ogni singola copia di quella rete neurale di imparare nozioni nuove a ritmi finora inimmaginabili.

Gli ultimi modelli linguistici, infine, secondo Hinton sono in grado di effettuare ragionamenti, risolvendo semplici problemi. Oggi possono essere considerati al livello di una persona con un quoziente di intelligenza sotto la media, ma in pochi anni potrebbero arrivare a un QI superiore a 200, rendendoli quindi estremamente pericolosi per il loro potere manipolativo.

Ciò che oggi ferma i sistemi di intelligenza artificiale dal conquistare il mondo, oltre al fatto che ancora non hanno raggiunto estremi livelli di intelligenza e di capacità di azione, è la mancanza di obiettivi. Noi esseri umani abbiamo obiettivi biologici che ci spronano a compiere certe azioni, come la sopravvivenza (mangiare e bere), l’incolumità (evitare il dolore), la riproduzione (piacere sessuale), solo per menzionare i più forti. Per ottenere questi obiettivi noi creiamo dei sotto-obiettivi che ci agevolano nel compito, come trovare un lavoro, trovare un partner, acquisire risorse (ricchezza) che rendono il raggiungimento degli obiettivi primari più facile e più duraturo.

Le macchine non hanno obiettivi, ma se un giorno qualcuno dovesse trovare il modo di insinuare degli obiettivi fondamentali nella loro programmazione, poco dopo esse potrebbero rendersi conto che acquisire potere rappresenterà un eccellente sotto-obiettivo, e inizierebbero a cercare di acquisire più potere possibile. Quasi sicuramente a nostro svantaggio.

La soluzione?

Hinton non ha una soluzione a portata di mano. L’ideale sarebbe fare in modo che queste entità intelligenti operassero solamente per il benessere dell’umanità, un tema noto come il problema dell’allineamento, che però è reso più difficile dalla presenza di esseri umani che invece vogliono usare l’AI per fini violenti, come ad esempio la creazione di robot militari o “killer robot”. Il settore sta cercando di costruire confini o “guardrail” per impedire che l’intelligenza artificiale sfugga di mano, ma se questi sistemi davvero diventeranno più intelligenti di noi, vi è sempre dietro l’angolo la possibilità che riescano a superare qualsiasi confine che sarà loro imposto.

Avrebbe senso, secondo Hinton, smettere di continuare a sviluppare questa tecnologia, ma l’ipotesi è praticamente impossibile, visto che vi è concorrenza fra Paesi, come Stati Uniti e Cina, e per fermare lo sviluppo dell’AI servirebbe un accordo internazionale fra tutti gli attori, attuali e potenziali. Cosa impraticabile.

Alla richiesta di uno spettatore se Hinton, che ha degli investimenti in start-up che sviluppano grandi modelli linguistici (LLM), avrebbe continuato a dare soldi a quel tipo di ricerca, la risposta è stata affermativa. Il motivo, secondo il ricercatore, è che i LLM possono essere molto utili, e che i problemi citati in precedenza devono essere risolti dalla politica, non dalla tecnologia.

Insomma, dobbiamo preoccuparci?

A parere di chi scrive, Hinton – brillantissimo ricercatore fuori dagli schemi – già in passato si è lasciato trasportare dalle potenzialità della tecnologia, esagerando e in certi casi estremizzando le sue affermazioni. Quello sui radiologi è un esempio classico: in teoria potrebbe anche avere ragione, in pratica vi sono mille dettagli che non aveva considerato prima di esprimere il suo giudizio tranchant.

Il problema dell’allineamento non va sottovalutato, ma dopo la pubblicazione di ChatGPT in molti stanno vedendo in quel sistema cose che in realtà non esistono. Quando Hinton dice che GPT “sa” qualcosa, oppure che “detiene conoscenza”, si sta avventurando in un territorio molto accidentato. I LLM, secondo ricercatori infinitamente più esperti del sottoscritto, non “sanno” un bel niente, se non rapporti statistici fra parole. Sembra che sappiano le cose che scrivono, ma è un’illusione che li rende anni-luce distanti dal rappresentare quel tipo di intelligenza dotata di QI di cui parla Hinton.

Nella platea di chi legge è naturale pensare “se lo dice il padre dell’AI, dev’essere così”; del resto se non demandiamo questi ragionamenti agli esperti, di chi ci possiamo fidare? La realtà purtroppo è più complessa, e il dubbio sempre dietro l’angolo. Le preoccupazioni di Hinton sono condivise da alcuni ricercatori, ma non da altri, che pure conoscono i LLM come le loro tasche.

Il dilemma che affrontiamo è complesso: da un lato, c’è il rischio di inibire l’evoluzione di tecnologie in grado di favorire progressi straordinari in diversi settori. Ricordiamo, ad esempio, quanto le ricerca medica stia beneficiando del deep learning per estendere la comprensione e accelerare i risultati. D’altro canto, esiste il pericolo di adottare strategie di difesa inadeguate o inefficaci. Se l’intelligenza artificiale dovesse effettivamente rappresentare per noi un rischio esistenziale, un’analisi dettagliata delle potenziali minacce, simile a quanto si pratica in ambito cybersecurity con il threat modeling, diventerebbe indispensabile. Questo ci permetterebbe di implementare le precauzioni corrette. Allo stato attuale, ci stiamo avvicinando ai LLM come se fossero sistemi intelligenti, e stiamo tentando di definire normative per governarli. Tuttavia, è fondamentale non precipitare le decisioni, ma piuttosto ricercare una comprensione approfondita di queste tecnologie. Potrebbe essere errato attribuire loro un’intelligenza che non possiedono e tale fraintendimento potrebbe distorcere la nostra percezione e gestione dei LLM. Dobbiamo dunque muoverci con consapevolezza prima di imporre qualsiasi forma di regolamentazione troppo stringente.