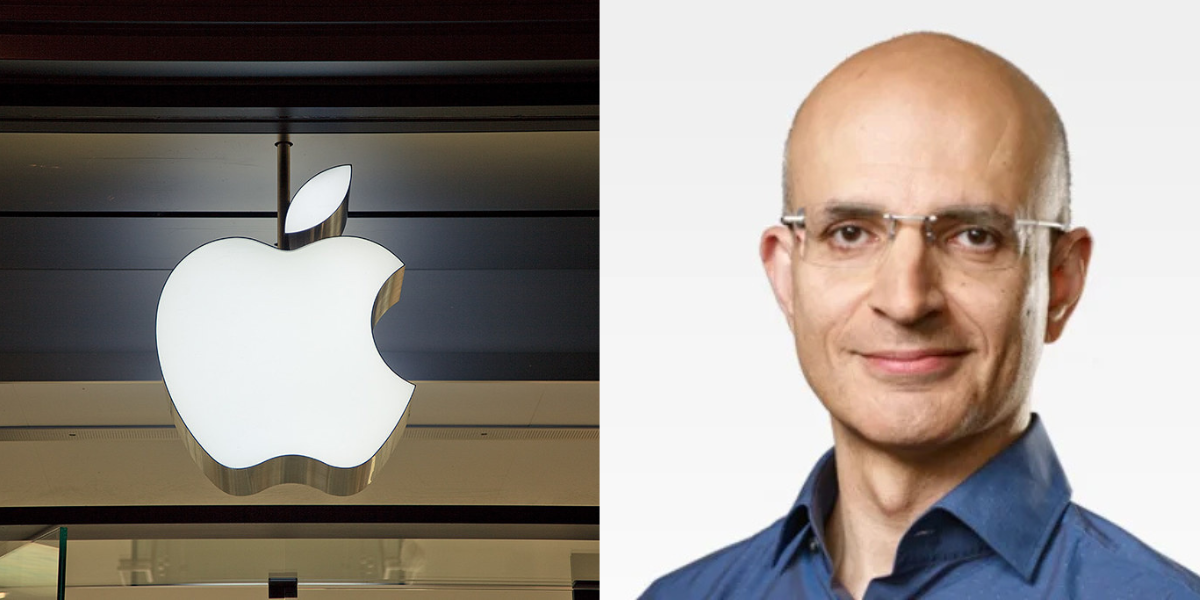

Non è la famosa Apple Intelligence con cui Cupertino dirà finalmente la sua nel settore dell’Intelligenza artificiale rianimando la vecchia Siri, ma certamente anche questo progetto collaterale, sviluppato dal team interno DataComp, serve a dimostrare ai detrattori della Mela morsicata che la Big Tech statunitense non è rimasta con le mani in mano.

CHI HA SVILUPPATO DATACOMP

L’algoritmo in questione risponde al nome di DCLM-7B e, oltre a essere stato sviluppato dagli ingegneri della società di Cupertino, risulta una collaborazione con i ricercatori delle Università di Washington, Tel Aviv e del Toyota Institute of Research. Il progetto nato nel cuore del DataComp for Language Models è open-source e pubblicato gratuitamente sulla piattaforma Hugging Face.

We have released our DCLM models on huggingface! To our knowledge these are by far the best performing truly open-source models (open data, open weight models, open training code) 1/5

— Vaishaal Shankar (@Vaishaal) July 18, 2024

DUE VERSIONI PER L’INTELLIGENZA ARTIFICIALE DI APPLE

Secondo quanto si apprende anche da alcuni post via X di Vaishaal Shankar, ricercatore Apple che ha anticipato dettagli prima dell’effettiva distribuzione, l’azienda guidata da Tim Cook ha realizzato due versioni di questa Intelligenza artificiale: una “standard”, con 7 miliardi di parametri, e una ridotta che si affida a 1,4 miliardi di parametri. Il modello maggiore è disponibile sotto la Sample Code License di Apple, mentre il più piccolo è stato rilasciato sotto Apache 2.0, per l’uso commerciale, la distribuzione e la modifica.

QUANTO SONO INTELLIGENTI LE AI DI APPLE?

Secondo Apple il suo algoritmo di punta è in grado di superare la rivale francese Mistral-7B (si tratta del principale prodotto europeo in tema, il cui studio di sviluppo ha chiuso poche settimane fa un round da 600 milioni di euro: tra gli azionisti Lightspeed Venture Partners, Andreessen Horowitz, Nvidia, Samsung Venture Investment Corporation, Salesforce Ventures, Belfius, Bertelsmann Investment, BNP Paribas, Bpifrance e Cisco) e sarebbe in grado di rivaleggiare con Llama 3 di Meta e Gemma di Google.

COSA DICONO I TEST

Nei test MMLU nei quali viene messa alla prova la comprensione linguistica multitasking di massa il progetto di Apple ha portato a casa un 63,7%, che lo avvicina alle prestazioni di Mistral-7B-v0.3 (62,7%), Llama3 8B (66,2%), Gemma di Google (64,3%) e Phi-3 di Microsoft (69,9%).

Invece, la versione da 1,4B del modello, addestrata con il Toyota Research Institute su 2,6 trilioni di token, si è fermata a una valutazione di 39,97% dimostrandosi dunque un possibile avversario di Qwen-1.5B e Phi-1.5B che hanno degli indici rispettivamente del 37,87% e del 35,90%.