Se DeepSeek aveva squassato i mercati occidentali, terrorizzando le Big Tech statunitensi, Kimi K2 si ripromette di essere il nuovo spauracchio di OpenAi, Meta, Amazon, Microsoft e tutte le grandi software house che nella fornace dell’intelligenza artificiale stanno buttando miliardi a ritmo serrato.

COS’HA DI SPECIALE L’AI CINESE KIMI K2?

Secondo quanto riportano i media di settore, saremmo di fronte a un modello di linguaggio di grandi dimensioni dotato di oltre mille miliardi di parametri, cifra che – se confermata da test possibilmente indipendenti – lo renderebbe un peso massimo a livello globale.

Proprio i media enfatizzano che Kimi K2 ha una architettura “mixture-of-experts” che permette la suddivisione dei compiti in sotto-reti senza che la singola operazioni monopolizzi perciò le intere risorse a disposizione, gestite da un nucleo centrale che decide in tempo reale chi fa cosa, attivando solo una frazione dei parametri totali in un dato momento (precisamente 32 miliardi).

Questo approccio, viene spiegato, si traduce in un’efficienza a dir poco competitiva che, almeno su carta, permette a questa nuova Intelligenza artificiale di essere competitiva sia in fase di addestramento sia di inferenza, allocando solo la potenza di calcolo necessaria.

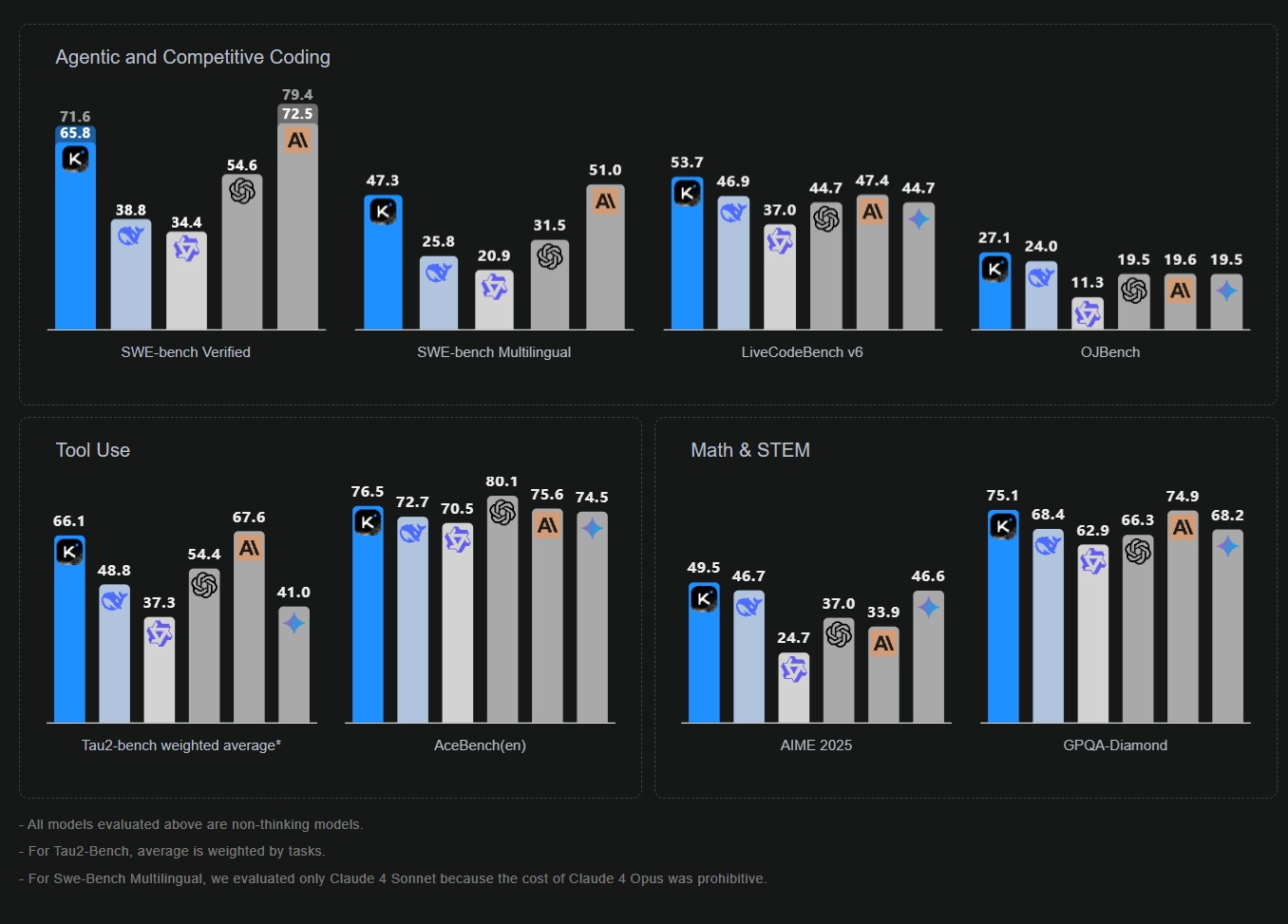

COSA DICONO I PRIMI TEST

I primi test su Kimi K2 parlano di prestazioni che eguagliano o superano i principali modelli proprietari in benchmark chiave per la programmazione e la matematica. Per esempio, su SWE-Bench Verified, un sottoinsieme del benchmark di ingegneria del software SWE-Bench convalidato da esseri umani, Kimi K2 ha ottenuto un punteggio del 65,8% contro il 54,6% di GPT-4.1. Questo benchmark include 500 compiti reali di correzione di bug su GitHub, che un modello di AI deve risolvere generando una patch che superi tutti i test unitari. Un punteggio del 65,8% per Kimi K2 significa che ha riparato automaticamente quasi due terzi di questi problemi. Su LiveCodeBench, un benchmark di codifica end-to-end, Kimi K2 ha raggiunto il 53,7% contro il 44,7% di GPT-4.1. Nel ragionamento matematico (MATH-500), ha toccato il 97,4%, superando leggermente il 92,4% di GPT-4.1.

IN COSA È UN DRAGO L’AI DEL DRAGONE

Ma l’aspetto interessante che potrebbe renderlo molto competitivo è un altro. La sua particolare architettura, sull’onda di una strada affine battuta a suo tempo da DeepSeek, lo rende infatti più economico dei rivali: Kimi K2 offre una politica di prezzo a circa 0,14 euro per milione di token in input e 2,30 euro per milione di token in output. GPT-4.1 di OpenAI costa 1,80 euro per milione di token in input e 7,30 euro per l’output e Claude Opus 4 di Anthropic si attesta persino sui 13,70 euro e 68,50 euro. Banalizzando, una grande azienda che voglia sfruttare le intelligenze artificiali per elaborare milioni di token al giorno, vedrà nel preventivo fornito da Kimi K2 costi tipici dei modelli di fascia media, ma potenza di calcolo paragonabili a quelli statunitense di fascia premium.

CHI HA SVILUPPATO KIMI K2?

Come per tutte le innovazioni che arrivano dal Dragone non è sempre facile reperire informazioni precise e dettagliate. Sappiamo che la software house che ha architettato l’algoritmo di Kimi K2 è una startup fondata soltanto nel 2023, Moonshot da Yang Zhilin, imprenditore laureato all’Università di Tsinghua, il cui nome al momento non dice niente, ma nell’ambiente potrebbe presto avere una eco paragonabile a quelle di Sam Altman o dei fratelli Amodei.

Non sorprende di veder figurare, tra i principali investitori della startup, colossi connazionali del calibro di Alibaba e Tencent. Il suo chatbot Kimi, basato su un precedente LLM, nel novembre 2024 risultava già il terzo più utilizzato in Cina, secondo Counterpoint, società di ricerche di mercato con sede a Hong Kong.